传统GPU驱动模型的能耗困境

当前主流大语言模型(LLM)如ChatGPT依赖GPU芯片进行训练与推理,此类模型在处理海量数据时需要强大算力支撑,导致能耗问题日益凸显。数据中心为支持聊天机器人等应用消耗大量电力,引发业界对可持续发展的担忧。研究团队针对这一痛点展开技术攻关,提出更智能的数据处理方法。

1位架构实现算力优化

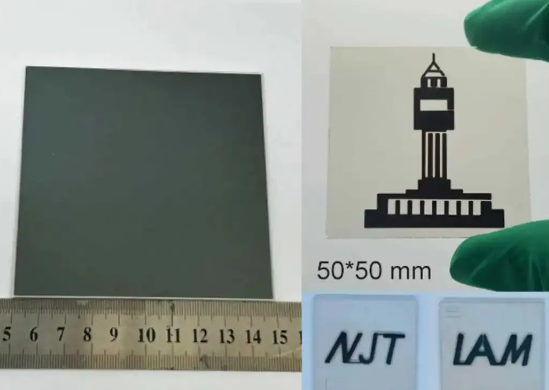

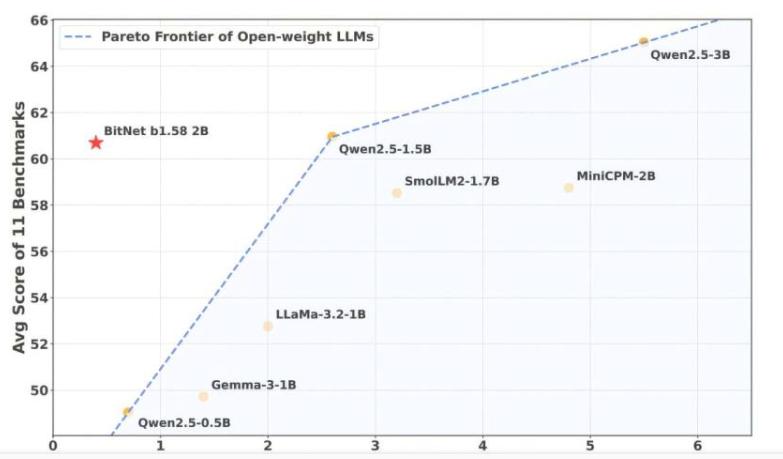

新模型摒弃传统8位或16位浮点数存储权重的方式,转而采用“1位架构”。其核心创新在于将模型权重简化为-1、0、1三种离散值,使推理过程仅需基础加减法运算。这种设计极大降低了内存占用与CPU处理负担,实验数据显示该架构在保持性能的同时,内存需求减少至传统方案的1/16,能耗降低超90%。研究团队强调,此方法使普通计算机或移动设备即可运行高效AI模型,无需依赖专业GPU硬件。

BitNet b1.58模型与专用运行环境

为适配1位架构,团队开发了配套运行时环境bitnet.cpp。该系统针对离散权重矩阵优化内存分配与指令调度,支持20亿参数规模的模型在单核CPU上稳定运行。测试结果表明,新模型在CPU环境下的推理速度接近传统GPU方案,且模型精度损失控制在可接受范围内。在MNIST、GLUE等基准测试中,其性能表现与同类GPU模型相当,部分场景下甚至实现超越。

本地化部署提升隐私与能效

上海油压工作室该技术突破为AI应用带来双重价值。在隐私保护层面,用户数据无需上传云端即可完成处理,支持完全离线的智能助手开发。研究团队在树莓派等边缘设备上成功部署聊天机器人系统,响应延迟低于300毫秒,且支持断网运行。在能效层面,单个推理任务的耗电量较传统方案减少92%,单次交互能耗不足0.03Wh。这一特性使其在移动终端、物联网设备等场景中具备显著优势。